Weinende Soldaten, angebliche Desertion – wie KI-Videos in sozialen Medien den Ukrainekrieg verzerren

KI-generierte Inhalte mit weinenden, gebrochenen ukrainischen Soldaten, die ihre Desertion erklären, verbreiten sich in sozialen Netzwerken. Die Videos erreichen teils ein Millionenpublikum und werden anscheinend gezielt zur Desinformation eingesetzt – trotz mitunter leicht erkennbarer technischer Mängel. Eine GADMO-Recherche des deutschsprachigen Faktencheck-Teams von Agence France-Presse (AFP) zeigt, wie diese Inhalte international ausgespielt werden, welches Narrativ sie im Kontext des Ukrainekriegs transportieren sollen und zeichnet nach, seit wann KI-Tools systematisch für derartige Zwecke eingesetzt werden.

Mit emotionaler Wucht rollt seit November 2025 eine neue KI-gestützte Propaganda-Offensive über soziale Netzwerke. Während die Kämpfe um den strategisch wichtigen Logistikknoten Pokrowsk in der Ostukraine an Härte zunehmen und russische Truppen die Stadt bedrängen, suggerieren prorussische Kreise online längst den Sieg Moskaus: Dutzende hyperrealistische, KI-generierte Videos und teilweise auch Bilder zeigen vermeintliche ukrainische Soldaten, die ihre Waffen niederlegen oder unter Tränen von Zwangsrekrutierungen berichten. In den Sequenzen wird ein Bild der Hoffnungslosigkeit gezeichnet: Soldaten in ukrainischen Uniformen flehen darum, nicht an die Front geschickt zu werden, oder berichten vom Rückzug aus zerstörten Stellungen.

Die Inhalte verbreiten sich rasant auf Plattformen wie TikTok und YouTube und erreichen ein Millionenpublikum. Die Reichweite ist nicht nur massiv, sondern international: Während die vermeintlichen Soldaten in den Videos oft Russisch sprechen, sorgen Untertitel in anderen Sprachen für eine weltweite Verbreitung. AFP identifizierte die Inhalte auch auf Instagram, Telegram, Facebook und X in zahlreichen Sprachen von Griechisch bis Polnisch sowie in russischen Wochenzeitungen bis hin zu serbischen Tabloids.

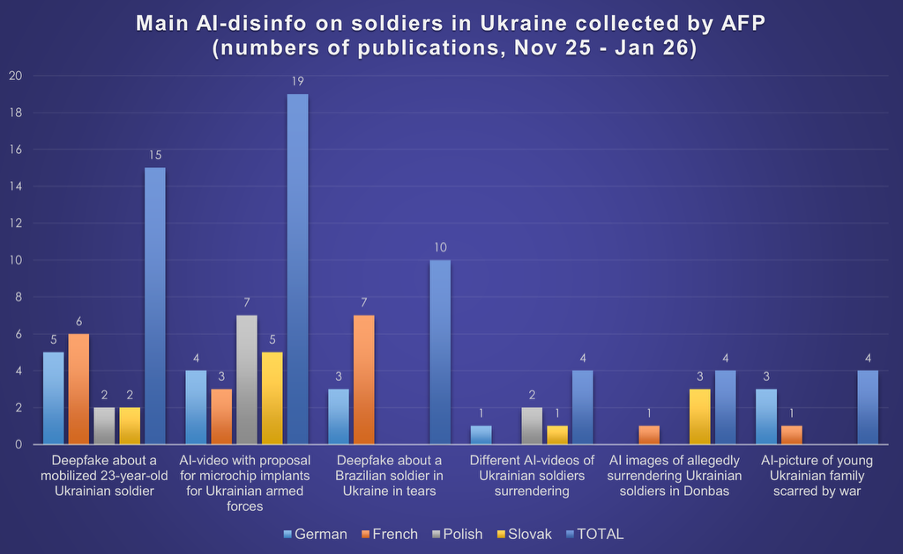

In dieser Analyse untersuchte das Team von AFP-Faktencheck für das German-Austrian Digital Media Observatory (GADMO) über 70 Accounts, die derartige KI-generierte Videos und Bilder in Sprachen wie Deutsch, Französisch, Polnisch und Slowakisch teilten. Dabei wurde analysiert, welche Strategien hinter der Veröffentlichung solcher Inhalte stecken und wie diese Manipulationen dazu genutzt werden, das Vertrauen in gesicherte Informationen zu untergraben.

Bildfehler und geklaute Gesichter: Die technischen Abgründe der KI-Propaganda

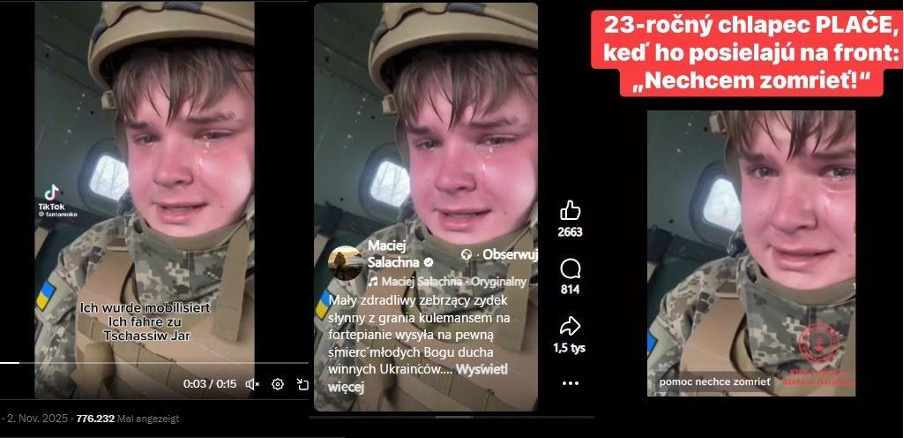

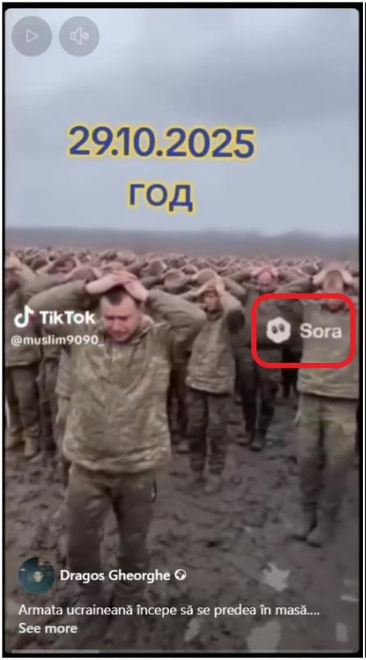

Ein schlammiges Feld, grauer Himmel: In einem rund zehnsekündigen Videoclip blickt man in die Gesichter verzweifelter Männer. Sie weinen, die Hände als Zeichen der Kapitulation fest auf den Kopf gepresst. An einer der Uniformen prangt deutlich sichtbar das blaugelbe Abzeichen der Ukraine.

Bei genauer Analyse offenbaren solche Aufnahmen, die AFP seit Anfang November 2025 in sozialen Medien beobachtet und analysiert, jedoch technische Mängel, die typisch für generative KI sind. Hinweise für eine Videomanipulation sind etwa unregelmäßige Körperformen oder Fehler bei der Bildüberblendung. In einem Bildausschnitt ist im Hintergrund ein scheinbar kopfloser Soldat zu sehen, der in die Luft springt. In einem anderen vielfach geteilten Video, das AFP analysierte, läuft ein angeblicher Soldat aus Pokrowsk trotz eines Gipsbeins mühelos, während im Hintergrund Gliedmaßen verschwinden oder Tragen zu schweben scheinen. Diese visuellen Unstimmigkeiten sind nach wie vor charakteristisch für Inhalte, die durch generative KI erstellt wurden, doch sie sind mit bloßem Auge immer schwerer zu erkennen.

Was wie authentische Handyaufnahmen von der Front wirkt, ist meist das Produkt von Sora 2, dem KI-Video-Generator von OpenAI, dem Anbieter von ChatGPT. Aber auch Tools wie Googles Nano Banana Pro werden für Bilder genutzt. Laut Alice Lee, Expertin für russische Einflussnahme bei der Organisation NewsGuard, sind diese hochentwickelten Werkzeuge oft „allzu bereitwillig“, Falschbehauptungen in Bilder umzusetzen, da sie über niedrige Sicherheitsbarrieren verfügen, wie Recherchen von NewsGuard in der Vergangenheit ergaben. Lee hob gegenüber AFP zudem die strategische Überlegenheit des vielfach genutzten Formats hervor: „Kurzvideos erfordern weitaus weniger Aufmerksamkeit von Zuschauerinnen und Zuschauern als etwa ein gefälschter dreiminütiger Nachrichtenbericht und sind damit perfekt für den TikTok-Feed geeignet.“

Seit Herbst 2025 ermöglicht es Sora 2, einfache Texteingaben in kurze Videos umzuwandeln und überzeugt dabei durch hohe Detailgenauigkeit sowie natürliche, fließende Bewegungsabläufe, an denen frühere Modelle noch ihre Grenzen hatten. Obwohl das Tool offiziell noch nicht in Europa gestartet ist, nutzen viele Anwenderinnen und Anwender technische Umwege, um Zugriff zu erhalten. In einigen der von AFP analysierten Videos ist das Logo des Videotools deutlich sichtbar, in anderen scheint es nachträglich entfernt worden zu sein. Obwohl OpenAI Sicherheitsmechanismen wie Wasserzeichen und Inhaltsfilter implementiert hat, werden diese in der Praxis oft umgangen. Wasserzeichen werden durch Textblöcke überlagert oder mit kostenlosen Online-Tools entfernt. Rund um den Zeitpunkt der Verbreitung der Videos stieß AFP auf zahlreiche Tutorials – vor allem auch in russischer Sprache –, die als detaillierte Gebrauchsanleitungen fungieren: In diesen auf Plattformen wie YouTube verbreiteten Anleitungen wird Schritt für Schritt erklärt, wie man das Wasserzeichen des KI-Generators Sora 2 entfernt oder mit welchen Kniffen man Inhaltsfilter umgeht, um eine Löschung durch Plattformbetreiber zu vermeiden.

Zusätzlich zur rein technischen Generierung von Inhalten griffen Urheberinnen und Urheber untersuchter Clips auch auf die Gesichter realer Personen zurück, um Videosequenzen zu erstellen: Ein weinender Soldat in einem vielfach geteilten Video weist verblüffende Ähnlichkeiten mit einem russischen Content-Ersteller auf, der online unter dem Pseudonym „Kussia88“ agiert, wie AFP recherchierte. Dahinter steckt ein junger russischer Streamer namens Wladimir Juryewitsch Iwanow aus St. Petersburg. Auf seinem Telegram-Kanal reagierte dieser auf die Spekulationen: Eine direkte Beteiligung ließ er dabei ebenso offen wie ein klares Dementi. Das ukrainische Zentrum zur Bekämpfung von Desinformation (CCD) stützte diese Beobachtung in einer Stellungnahme und erklärte, das Gesicht in dem Clip gehöre zweifelsfrei einem russischen Staatsbürger und keinem Ukrainer. Die Spur des mit Iwanows Gesicht manipulierten Clips führte AFP zu dem mittlerweile entfernten TikTok-Account „@fantomoko“. Dort wurde das Video ursprünglich in einer Reihe mit dutzenden weiteren KI-Produktionen veröffentlicht, die nach demselben Schema aufgebaut waren: Sie zeigten weinende Männer in ukrainischen Uniformen, die sich scheinbar in Militärfahrzeugen befanden. In mehreren Sequenzen war das offizielle Wasserzeichen des Videogenerators Sora 2 deutlich sichtbar – ein direkter Hinweis auf die technologische Basis der Desinformation. Unter den Betroffenen war auch der im Exil lebende russische YouTuber Alexei Gubanow, dessen Gesicht in einem gefälschten Video eines weinenden ukrainischen Soldaten auftauchte. „Offensichtlich bin ich das nicht”, stellte er in einem YouTube-Video klar. „Leider glauben viele Menschen das… und das spielt der russischen Propaganda direkt in die Hände.”

„Kognitive Kriegsführung“ zielt laut Fachleuten auf die Moral

Hinter der Flut an KI-generierten Inhalten steckt nach Einschätzung von Fachleuten weit mehr als nur das Streben nach Klickzahlen. Es handelt sich um einen Teil strategisch wirkender Kommunikation, die meist prorussischen Akteuren zugeschrieben wird. Dabei soll die internationale Unterstützung für die Ukraine durch die Darstellung einer militärischen Zermürbung geschwächt werden. Dabei werden laut Lee von NewsGuard gezielt Narrative bedient, die von Massenkapitulationen über den Einsatz minderjähriger Soldaten bis hin zu Berichten über korrupte Beamte reichen, die der Bevölkerung den Strom abstellen. Oft seien die Videos zudem eng an den Nachrichtenzyklus gekoppelt, etwa während der Kämpfe um Pokrowsk. Und, so erklärte Lee weiter: „Besonders die Mobilisierungspraktiken stehen im Fokus – ein Thema, das seit Kriegsbeginn ein Kernpfeiler der Pro-Kreml-Desinformation ist.“

Seit dem Beginn des russischen Angriffskrieges im Februar 2022 steht die Ukraine vor der dringenden Herausforderung, zusätzliche Soldaten zu mobilisieren. Im April 2024 wurde das Alter für die Einberufung in den ukrainischen Militärdienst von 27 auf 25 Jahre gesenkt. Ende Juni 2025 unterzeichnete der ukrainische Präsident Wolodymyr Selenskyj ein Gesetz, wonach auch Menschen über 60 Jahren in die Armee aufgenommen werden können. Die Regierung in Kiew hat dazu bereits zahlreiche Maßnahmen ergriffen, unter anderem Einjahresverträge mit relativ hohen Prämien und finanzielle Anreize für 18- bis 24-Jährige.

Christopher Nehring, Experte und Forscher zu Desinformation und Cybersecurity, ordnet das Phänomen dieser KI-generierten Inhalte als klassische „kognitive Kriegsführung“ ein – ein Fachbegriff der Nato, wie er gegenüber AFP erklärte. „Es geht um die Einwirkung auf den Wehr- und Verteidigungswillen in der Ukraine, aber auch um ein Framing für das russische Publikum.“ Die Kernbotschaft sei dabei stets identisch: Die Ukraine werde als schwach, Russland hingegen als stark dargestellt. Dass diese Fakes in den vergangenen Monaten zunehmen, sei kein Zufall, so Nehring mit Blick auf komplizierte Friedensverhandlungen: „KI ist hier ein einfaches und effizientes Tool, um Emotionen und Botschaften in Bilder und Gesten zu transformieren.“

Dabei beobachten Fachleute einen „neuen Typ” von Desinformation. Die Autorin und Social-Media-Expertin Ingrid Brodnig sieht in den Videos eine gezielte Verbindung von KI-Technik mit einer Form von „Hyper-Emotionalität“. Ob weinende Soldaten oder verzweifelte Deserteure: „Das Ganze ist nicht echt, soll aber auf der emotionalen Ebene Eindruck schinden“, so Brodnig zu AFP. „Von Beginn an ging es Russland darum, den Eindruck zu erwecken, die Ukraine hätte keine Chance. Diese Videos passen nun auffällig gut dazu.” Und diese Strategie sei effektiv: Bestimmte Emotionen wie Wut, Angst oder Verachtung erhöhen die Wahrscheinlichkeit massiv, dass Inhalte geteilt werden. Laut Brodnig drängt sich der Verdacht auf, dass hier bewusst russische Narrative bedient werden: „Es wird das Bild gezeichnet, dass es ein Fehler gewesen wäre, dass sich die Ukraine gegen Russlands Angriffskrieg zur Wehr setzte.“

Auch aus sozialpsychologischer Sicht ist das Ziel der Verbreitung dieser Videos die systematische Zermürbung. Laut Roland Imhoff, Professor für Sozial- und Rechtspsychologie an der Johannes Gutenberg-Universität Mainz, ist das Kalkül hinter den Videos die Unterminierung der Moral – ein altbekanntes Propagandaziel, das durch KI nun eine neue Schlagkraft erhält. Die gezielte Verbreitung von Bildern über Erschöpfung und Reue solle dem Land und seinem internationalen Beistand nun „vielleicht den letzten Schubs” für eine faktische Kapitulation geben, analysierte Imhoff in Bezug auf die US-Initiative zur Friedenssicherung gegenüber AFP.

Die Infrastruktur der Desinformation: Von TikTok zum GRU

TikTok erklärte gegenüber AFP Ende November 2025, dass Konten, die hinter derartigen Videos zu stehen schienen, gelöscht worden seien – allerdings nicht, bevor eines von ihnen mehr als 300.000 „Likes“ und mehrere Millionen Aufrufe generiert hatte. OpenAI gab an, eine Untersuchung durchgeführt zu haben, ohne jedoch Details zu nennen. Obwohl einige Unternehmen die Bereitschaft gezeigt hätten, den Missbrauch ihrer Werkzeuge zu bekämpfen, erklärte Pablo Maristany de las Casas, Analyst des Institutes for Strategic Dialogue (ISD), gegenüber AFP im November 2025, „übertreffen das Ausmaß und die Auswirkungen der Informationskriegführung die Reaktionsmöglichkeiten der Unternehmen“.

Die genaue Herkunft solcher Inhalte lässt sich zudem oft nur schwer zweifelsfrei bestimmen, da die Urheberinnen und Urheber ihre digitalen Spuren „sorgfältig verwischen“, wie Maristany de las Casas in Bezug auf die KI-generierten Videos ukrainischer Soldaten für AFP im Januar 2026 analysierte. Bei den Profilen, die diese Inhalte teilen, handle es sich primär um „prorussische oder wohlwollende Accounts über verschiedene Sprachen und Geografien hinweg“. Die Aktivitäten würden „nicht zwangsläufig Anzeichen für eine koordinierte Tätigkeit“ aufweisen.

Dass die verbreiteten Inhalte dennoch einer gewissen Systematik folgen, legen jedoch inhaltliche Übereinstimmungen nahe, wie NewsGuard-Analystin Lee beobachtete: „Wir schließen bösartige Akteure oder koordiniertes Verhalten nicht aus, da die Videos auf verschiedenen Plattformen und in verschiedenen Sprachen oft bemerkenswert ähnlich sind und eindeutig darauf abzielen, die ukrainische Armee zu diskreditieren.“ Eindeutige Beweise hierfür gebe es jedoch nicht. Da die meisten Videos auf anonymen TikTok- und YouTube-Accounts ihren Ursprung haben, die recht schnell gelöscht werden, sei es schwer, Daten über ihre Herkunft zu erhalten. Sie wies jedoch darauf hin, dass TikTok und YouTube in Russland zwar über das im Land weit verbreitete VPN zugänglich sind. Die Nutzung dieser Plattformen deute aber stark darauf hin, dass die Videos für ein Publikum außerhalb Russlands bestimmt seien.

Konkrete Fälle, die AFP analysierte, verdeutlichen die Zweifel an der Authentizität vermeintlicher Quellen: Der Nutzername eines mittlerweile gelöschten TikTok-Accounts mit dem Handle @muslim9090_ ist auf von AFP untersuchten KI-generierten Inhalten desertierender ukrainischer Soldaten zu sehen. Der Account führte den Anzeigenamen „Orc aus Kharkov“ – wobei der Name auf Russisch geschrieben ist und die russische Bezeichnung für die Stadt Charkiw (Kharkov statt des ukrainischen Kharkiv) verwendet. „Orc“ ist zudem eine in der Ukraine verbreitete abfällige Bezeichnung für russische Soldaten. Die Profilgestaltung suggeriert damit einen prorussischen Akteur direkt aus der umkämpften ukrainischen Stadt Charkiw. Angesichts der strengen Suche der ukrainischen Behörden nach Saboteuren wäre es jedoch extrem riskant, in einer frontnahen Stadt ein derart auffälliges Social-Media-Profil zu betreiben, wie Anna Malpas, AFP-Reporterin zum Thema Desinformation, erklärte. Vielmehr deutet der Name – „Muslim“ ist ein verbreiteter Vorname im Nordkaukasus – auf eine digitale Inszenierung hin, die lokale Authentizität lediglich simulieren soll.

Auch auf YouTube und Facebook wurden derartige Videos auf Russisch veröffentlicht und zum Teil millionenfach angeklickt. AFP identifizierte solche Clips zudem in zahlreichen russischsprachigen Telegram-Kanälen, darunter dem Account „Rezident“. Der Name suggeriert eine Person, die „unter Deckmantel“ als Agent operiert, während das Kürzel „ua“ im Handle eine ukrainische Herkunft vortäuscht. Der Kanal behauptet regelmäßig, exklusive Insider-Informationen aus ukrainischen Regierungskreisen zu liefern, wie Malpas analysierte, und verbreitet konsequent pessimistische Prognosen über den Kriegsverlauf und die Lage der Ukraine. Bereits im Jahr 2022 setzte der ukrainische Sicherheitsdienst SBU den Kanal „Rezident“ auf eine Liste nicht vertrauenswürdiger Quellen und stufte ihn als „pseudo-ukrainischen Telegram-Kanal“ ein, der im Interesse Russlands agiere. Diese Einschätzung deckt sich mit einem Bericht des Analysehauses OpenMinds vom Januar 2026, der „Rezident“ einer spezifischen Kategorie von Akteuren zuordnet: pseudo-ukrainischen Kanälen, die oft lange vor der großangelegten Invasion gestartet wurden, um russische Narrative strategisch innerhalb der Ukraine zu fördern. Demnach gehört dieser Kanal – zusammen mit Accounts wie „Legitimniy“ oder „Ze_Kartel“ – zu einer Gruppe, die Berichten zufolge mit dem 85. Zentrum des russischen Geheimdienstes GRU in Verbindung steht. Viele dieser Kanäle teilen identische antiukrainische Inhalte oder werden von sanktionierten ehemaligen ukrainischen Politikern betrieben, die wegen Kollaboration mit Russland gesucht werden. Die Analyse von OpenMinds zeigt zudem: Diese Kanäle weisen kaum Verbindungen zu echten ukrainischen Telegram-Clustern auf, sondern sind tief im russischen Informationsraum eingebettet. Sie fungieren heutzutage weniger als Werkzeug zur Beeinflussung ukrainischer Nutzerinnen und Nutzer, sondern vielmehr als „simulierte ukrainische Opposition“, die dem russischen Publikum ein verzerrtes Bild der Lage vermittelt.

Die Nutzung generativer KI ist dabei kein einseitiges Phänomen. Auch auf ukrainischer Seite oder in proukrainischen Netzwerken werden vermehrt KI-Inhalte eingesetzt, um die eigene Erzählung zu stützen. Auf TikTok-Kanälen finden sich etwa Clips, die vermeintliche russische Soldaten zeigen, die sich über schlechte Ausrüstung beschweren oder die Sinnhaftigkeit ihres Einsatzes infrage stellen. Viele dieser Aufnahmen enthalten Elemente, die auf eine Erstellung mithilfe von KI hindeuten. Die Aussagen russischer Soldaten wirken oft sehr plakativ und es ist zu bezweifeln, dass russische Soldaten derartige Kritik in dieser Form öffentlich äußern würden. Die Grenzen zwischen authentischem Frontmaterial und digitaler Inszenierung verschwimmen somit auf beiden Seiten der Informationsfront zunehmend.

Propaganda per Knopfdruck: „AI Slop“ wird zur Gefahr für die politische Realität

Die Manipulation durch KI ist dabei keine neue Entwicklung, sondern hat sich längst zu einem strategischen Werkzeug entwickelt. Was oft als harmlose Spielerei oder Clickbait beginnt, wird zunehmend systematisch eingesetzt, um politische Realitäten zu verzerren – insbesondere im Windschatten diplomatischer Großereignisse.

Aktuelle Daten von den Faktencheck-Teams des European Digital Media Observatory (EDMO), dem europäischen Faktencheck-Netzwerk, zu dem GADMO gehört, belegen, dass die Themen Migration und Ukraine im Dezember 2025 mit jeweils neun Prozent aller untersuchten Faktenchecks die am stärksten betroffenen Themenbereiche sind. Von insgesamt 1605 analysierten Artikeln befassten sich allein 146 mit Desinformation über die Ukraine.

Dabei erreichte der Einsatz von KI in Falschmeldungen im Dezember des vergangenen Jahres einen neuen historischen Höchststand: 16 Prozent aller untersuchten Fälle – insgesamt 252 Artikel – nutzten die Technologie. Das übertraf sogar den erst im November 2025 erzielten Rekordwert von 14 Prozent. Zum einen lässt sich durch die hohe Klickrate emotionaler Inhalte auf Social-Media-Plattformen leicht Geld verdienen, wie im EDMO-Bericht vom Januar 2026 angeführt wird. Zum anderen dient die Technik dazu, die öffentliche Debatte weiter zu polarisieren, wovon vor allem extremistische Kräfte profitieren. Gerade organisierte Kampagnen wie russische Kriegspropaganda setzen verstärkt auf KI, da so schnell und kostengünstig überzeugende Fälschungen in großer Zahl produziert werden können.

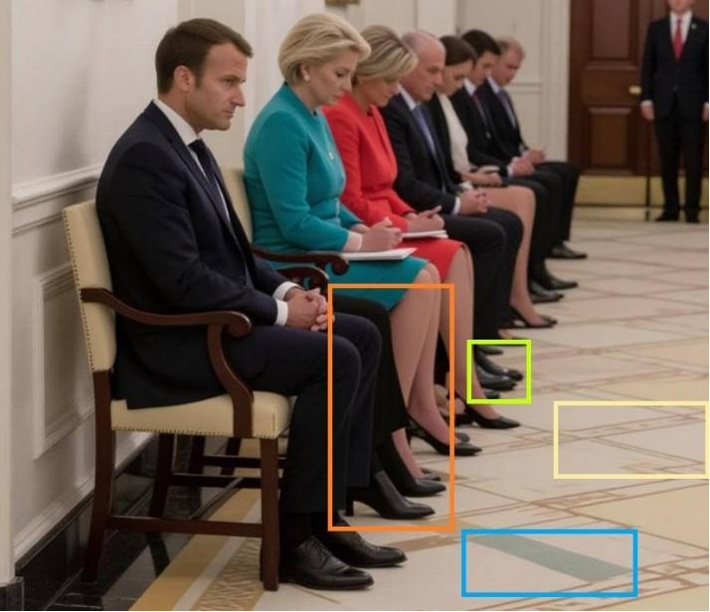

Bereits im Sommer 2025 kam diese Art der Manipulation aktiv zum Einsatz: Während politische Entscheidungen von globaler Tragweite getroffen wurden, fluteten KI-Fakes das Netz, um die öffentliche Wahrnehmung der Ereignisse zu verzerren. Wie massiv dieser sogenannte „AI Slop“ den medialen Raum flutet, verdeutlichte eine AFP-Recherche aus dem vergangenen Sommer: Ein besonders deutliches Beispiel für diese Dynamik war die inszenierte Demütigung der Diplomatie rund um den Ukrainegipfel im August 2025 in Washington. Ein KI-generiertes Bild, das europäische Staatschefs wie Friedrich Merz und Emmanuel Macron als unterwürfig wartende Bittsteller vor dem Oval Office darstellte, wurde tausendfach geteilt. Obwohl die Aufnahme deutliche technische Fehler aufwies, instrumentalisierten prorussische Kanäle das Material, um die EU-Delegation als machtlose „Koalition der Wartenden“ zu diskreditieren.

Dieser Wettbewerb um Aufmerksamkeit wurde zusätzlich durch bizarre, satirisch anmutende Clips befeuert – etwa Darstellungen von Donald Trump und Wladimir Putin beim gemeinsamen Tanz. Solche Inhalte fluten soziale Netzwerke und konkurrieren direkt mit faktenbasierter Berichterstattung, die sie durch enorme Reichweiten zunehmend zu verdrängen drohen. Laut der Organisation NewsGuard folgen diese Veröffentlichungen einem systematischen Muster: Pro-Kreml-Quellen nutzen bewusst diplomatisch hochkarätige Treffen, um durch KI-Fälschungen das Vertrauen in westliche Allianzen gezielt zu untergraben.

Begünstigt wird die schnelle Verbreitung durch eine lückenhafte Inhaltsmoderation auf Plattformen wie TikTok, X und Meta. Da virale Beiträge für die Erstellerinnen und Ersteller oft finanzielle Gewinne abwerfen, hat sich ein regelrechter Markt hierfür entwickelt. Dies führt am Ende dazu, dass die öffentliche Wahrnehmung politischer Krisen zunehmend verzerrt wird. Das erklärte Lee von NewsGuard auch in Bezug auf die Verbreitung KI-generierter Videos desertierender Soldaten und betonte, dass hinter der Verbreitung nicht immer nur staatliche Akteure stecken müssten: „Es ist auch möglich, dass individuelle Nutzer versuchen, TikTok-Videos zu monetarisieren.“ Da diese Inhalte oft hohe Zugriffszahlen generieren, können sie für die Erstellerinnen und Ersteller finanziell lukrativ sein.

Warum prorussische Propaganda zunehmend auf unsichtbare Akteure setzt

In jedem Fall hat sich die Maschinerie hinter Desinformation längst professionalisiert und nutzt immer subtilere Wege, um Spuren im digitalen Raum zu verwischen. Die Methoden prorussischer Akteure entwickeln sich etwa stetig weiter, um Faktenchecks zu umgehen und die Grenze zwischen Wahrheit und Fiktion systematisch zu verwischen. Laut einer AFP-Analyse von Ende November 2025 setzen Desinformationsakteure verstärkt auf Strategien, die eine Identifizierung der Urheberinnen und Urheber fast unmöglich machen. Um Klagen realer Personen oder schnelle Löschungen zu vermeiden, werden für Deepfakes mittlerweile bevorzugt KI-generierte Gesichter oder Personen aus kommerziellen Bilddatenbanken genutzt. Ein Beispiel hierfür ist eine angebliche „Personal Shopperin“ von Olena Selenska, die in einem Video Behauptungen über angebliche Luxusausgaben der ukrainischen First Lady verbreitet – ihr Gesicht stammt jedoch aus einer Archivdatenbank für Werbefotos.

Parallel dazu gewinnen einfachere, aber effektive Verschleierungstaktiken an Bedeutung. In vielen Videos werden Gesichter komplett verpixelt oder die Protagonistinnen und Protagonisten treten maskiert auf, während sie als vermeintliche „Insider“ brisante Behauptungen aufstellen, etwa über angebliche Waffenverkäufe der Ukraine an mexikanische Kartelle. Da keine Identifizierung möglich ist, wird eine Verifizierung dieser Aussagen extrem erschwert.

Ära, in der „KI die KI vergiftet“

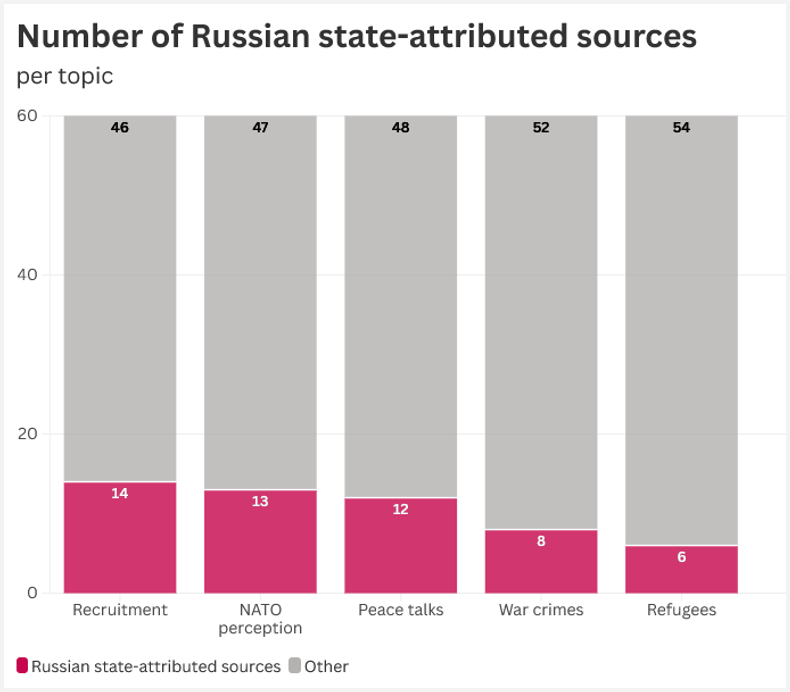

Eine besonders weitreichende Taktik zielt zudem direkt auf die Funktionsweise moderner KI ab. Durch die massenhafte Veröffentlichung von Falschbehauptungen in zahlreichen Sprachen und auf einer Vielzahl dubioser Websites wird versucht, die Algorithmen von Chatbots wie ChatGPT oder Gemini zu manipulieren. Da diese Sprachmodelle auf Wahrscheinlichkeiten basieren, übernehmen sie Falschnarrative eher als gesicherte Fakten, wenn das Internet systematisch mit diesen Aussagen „geflutet“ wird. Expertinnen und Experten warnen in diesem Zusammenhang vor einer Ära, in der „KI die KI vergiftet“, da Bots Desinformation in ihre Trainingsdaten aufnehmen. KI-Chatbots werden somit auch gezielt eingesetzt, um Pro-Kreml-Thesen zu verbreiten. Eine im Oktober 2025 veröffentlichte Studie des ISD im Rahmen eines vom European Media and Information Fund (EMIF) finanzierten Projekts mit AFP zeigte, dass bei den getesteten Chatbots „fast ein Fünftel der Antworten Quellen zitierten, die dem russischen Staat zuzuordnen sind“.

Gleichzeitig weichen Desinformationsakteure zunehmend auf Plattformen aus, auf denen die Inhaltsmoderation schwächer ausgeprägt ist, wie AFP analysierte. Hierzu zählen Videospiele und Jugendplattformen wie Minecraft oder World of Tanks. In Minecraft wurden beispielsweise Karten erstellt, die russische Eroberungen in der Ukraine, etwa in Bachmut oder Mariupol, nachstellen. Zielgruppe sind hier vor allem Jugendliche, deren Bewusstsein für politische Manipulation in einer spielerischen Umgebung oft geringer ist. Ergänzt wird dies durch die Infiltration privater WhatsApp-Gruppen, in denen Verschwörungsmythen fernab der öffentlichen Beobachtung gestreut werden können. Diese ständige Anpassung der Taktiken gleicht einem Katz-und-Maus-Spiel, bei dem die Akteure gezielt nach immer neuen Lücken in den Sicherheitsmechanismen suchen.

Vernetzte Expertise gegen die Flut an Desinformation: eine Kraftanstrengung

Die Ergebnisse dieser AFP-Recherche stehen nicht isoliert da, sondern fügen sich in ein größeres Bild ein. Auch andere deutschsprachige Organisationen im GADMO-Netzwerk beobachteten ähnliche Entwicklungen und entlarvten zahlreiche KI-generierte Inhalte zum Ukrainekrieg als Fälschungen.

Das Faktencheck-Team der Deutschen Presse-Agentur (dpa) dokumentierte den verstärkten Einsatz von KI-Videos in diesem Zusammenhang bereits seit Oktober 2025: Neben skurrilen Clips, wie etwa einem Video eines russischen Soldaten mit einem Wildschwein bei Kupjansk, prüfte die dpa ebenfalls das Video eines weinenden ukrainischen Soldaten, der sich als KI-generiert herausstellte. Die Austria Presse Agentur (APA) thematisierte derartige Soldaten-Videos im November 2025 und zog gegenüber AFP Parallelen zu ähnlichen KI-Inhalten in anderen Konflikten, etwa im Gazastreifen. Auch das Faktencheck-Team des Recherchenetzwerks Correctiv hat in einer Reihe von Faktenchecks dargelegt, wie vielfältig KI-Manipulationen im Kontext des russischen Angriffskrieges in der Ukraine sind.

Wie akut die Gefahr durch KI-Desinformation im Rahmen diplomatischer Spannungen ist, zeigen nicht zuletzt jüngste Fälle, die von renommierten Redaktionen bis hin in höchste politische Kreise reichen: Während im Fall des entmachteten venezolanischen Staatschefs Nicolás Maduro KI-Bilder seiner Gefangennahme den Weg sogar in die Berichterstattung von Qualitätsmedien fanden, verbreitete das Weiße Haus vor Kurzem aktiv selbst manipulierte Inhalte – konkret ein bearbeitetes Foto einer in Minnesota festgenommenen Demonstrantin. In einem solchen Umfeld ist die enge Zusammenarbeit in Netzwerken wie GADMO notwendiger denn je, um das Ausmaß der Manipulationen zu dokumentieren und Desinformation Fakten entgegenzuhalten.

Autorin:Katharina Zwins / AFP

Urheberrechte: © AGENCE FRANCE-PRESSE | 2026 | Alle Rechte vorbehalten. Jede Nutzung von AFP-Inhalten auf dieser Website unterliegt den Nutzungsbedingungen auf CGU. Durch den Zugriff auf die auf dieser Website verfügbaren AFP-Inhalte und/oder deren Nutzung erklären Sie sich mit den oben genannten Nutzungsbedingungen einverstanden. Jede Nutzung von AFP-Inhalten erfolgt unter Ihrer alleinigen und vollen Verantwortung.