GADMO und der EDMO Ireland Hub haben eine ausführliche Analyse zum Umgang von großen digitalen Plattformen mit Falsch- und Desinformation vorgelegt. Sie zeigt: Die Selbstauskünfte der Plattformen lassen zu wünschen übrig. Insgesamt tun sie zu wenig, um die Verbreitung von Falschbehauptungen und Desinformation einzudämmen.

In der Analyse wird konkret überprüft, ob Google, Meta, Microsoft, TikTok und X/Twitter die Vorgaben des Code of Practice on Disinformation einhalten. Dafür hat ein Team unabhängiger Wissenschaftler:innen Reports der Plattform-Unternehmen detailliert analysiert.

Der Code of Practice on Disinformation (CoP) ist eine von der EU Kommission initiierte Selbstverpflichtung, die u.a. die großen Technologiefirmen (Google, Meta, Microsoft, TikTok) unterzeichnet haben. Darin sind zahlreiche Regeln vorgesehen, dass und wie Plattformen gegen Des- und Falschinformationen vorgehen sollten. Dazu gehören z.B. Transparenzvorschriften, die Durchsetzung von Community-Richtlinien oder die Pflicht zur Zusammenarbeit mit Faktencheckern und Forschenden. Die erste Fassung des CoP wurde 2018 veröffentlicht und anschließend überarbeitet. Die aktuell gültige Fassung wurde 2022 veröffentlicht und enthält 128 konkrete Maßnahmen gegen Des- und Falschinformationen. Hier finden Sie den ganzen Text des Codes.

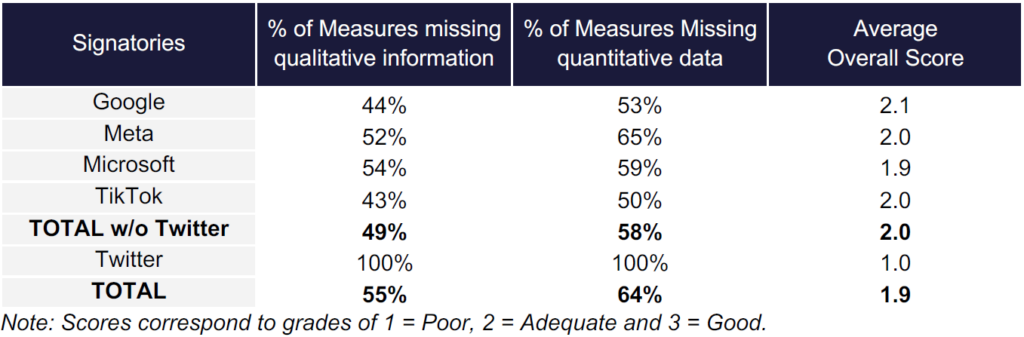

Anhand eines Bewertungsschemas und eines dreistufigen Kodierungsprozesses haben die Forschenden sowohl die qualitativen als auch die quantitativen Informationen der Plattformen ausgewertet und für jede Maßnahme eine Gesamtnote von 1 (schlecht), 2 (angemessen) oder 3 (gut) vergeben.

Informationen und Daten fehlen

Die Ergebnisse zeigen, dass die Qualität der Plattform-Reports insgesamt weniger als angemessen ist. Ungefähr die Hälfte der anwendbaren Maßnahmen wies unvollständige oder fehlende qualitative Informationen auf. Vor allem fehlten in 58 % der Fälle quantitative Daten.

Besonders schlecht schnitten die Plattformen im Kapitel „Empowering the Research Community“ ab. Die Zusammenarbeit mit externen, unabhängigen Wissenschaftler:innen sollte in Zukunft besser funktionieren, um die Vorgaben des CoP zu erfüllen. Auch für die Bereiche, die sich mit der Demonetarisierung von Desinformation oder dem Abwehren manipulativer Techniken befassen, stellt die Analyse mehrere Mängel fest. So fehlen beispielsweise Daten über die Bekämpfung von Fake Accounts und Fake Engagement.

Schlechteste Note für Twitter/X

Die Plattform X (ehemals Twitter) war bis vor einigen Monaten noch Unterzeichner des Code of Practice und hat dementsprechend auch einen Transparenzbericht eingereicht. In diesem fehlen aber zu fast allen Verpflichtungen Informationen und Daten, sodass X mit der schlechtestmöglichen Note bewertet werden musste.

Die Analyse der Plattform-Berichte macht deutlich, wie komplex das Monitoring von Plattform-Maßnahmen gegen Desinformation ist. Die Überprüfung kann prinzipiell mit zwei unterschiedlichen Ansätzen erfolgen: Entweder wird lediglich überprüft, ob die Berichtspflichten eingehalten werden. Oder man untersucht auch den Wahrheitsgehalt und die Vollständigkeit der von den Plattformen gelieferten Informationen. Letzterer Ansatz würde bedeuten, dass z.B. die wirksame Durchsetzung von Nutzungsrichtlinien überprüft werden müssten. Wie erfolgreich ist beispielsweise Instagram im Kampf gegen Fake Accounts? Oder ist Googles Werbenetzwerk wirklich in der Lage, Desinformation in Werbeanzeigen zu erkennen und zu blocken? Solche Fragen drängen sich auf, ihre Beantwortung erfordert allerdings entsprechende Ressourcen, Fachwissen und Datenzugang. Für eine sinnvolle Überwachung ist dieser investigative Ansatz aber unerlässlich.

Substanzielle Zweifel an den Angaben der Plattformen

Der vorliegende CoP Monitor konzentriert sich in erster Linie auf die Überprüfung der Berichtspflichten. Stellt aber schon in diesem Bereich zahlreiche Mängel fest. An mehreren Stellen konnten die Autor:innen substanzielle Zweifel an den Angaben der Plattformen feststellen. Beispiel TikTok: Das Unternehmen nimmt für sich in Anspruch, dass viele Regeln für politische Werbung für die eigene Plattformen nicht gelten. Denn politische Werbung ist verboten auf TikTok. Allerdings zeigen mehrere Untersuchungen, dass dieses Verbot nicht konsequent genug durchgesetzt wird.

Daher ist eine von zahlreichen Empfehlungen, die im CoP Monitor gemacht werden, das Plattform-Monitoring auszubauen und zu institutionalisieren. Das ist umso wichtiger, da der CoP bald zu einem Code of Conduct im Sinne des Digital Services Act werden könnte. Dann wären die Vorgaben des Code für die Plattformen quasi bindend und eine Missachtung könnte im äußersten Fall zu hohen Geldstrafen führen.

Falls Sie Fragen zum CoP Monitor oder GADMOs Arbeit im Bereich Plattform-Beobachtung haben, erreichen Sie uns unter [email protected].