Während der Diktatur des Assad-Regimes verschwanden Zehntausende im Folter-Gefängnis Sednaya in Syrien, darunter auch Frauen und Kinder. Mit dem Sturz des Regimes am 8. Dezember 2024 konnten Tausende von ihnen befreit werden. Berichte von Menschenrechtsorganisationen und den Vereinten Nationen belegen, dass es in Sednaya laut Fotos und Aussagen ehemaliger Häftlinge sadistische Folter und Massenhinrichtungen gab.

Medien wie der Guardian oder die New York Times konnten Videoaufnahmen und Fotos von der Befreiung der Gefangenen verifizieren. Die Aufnahmen sind von schlechter Qualität.

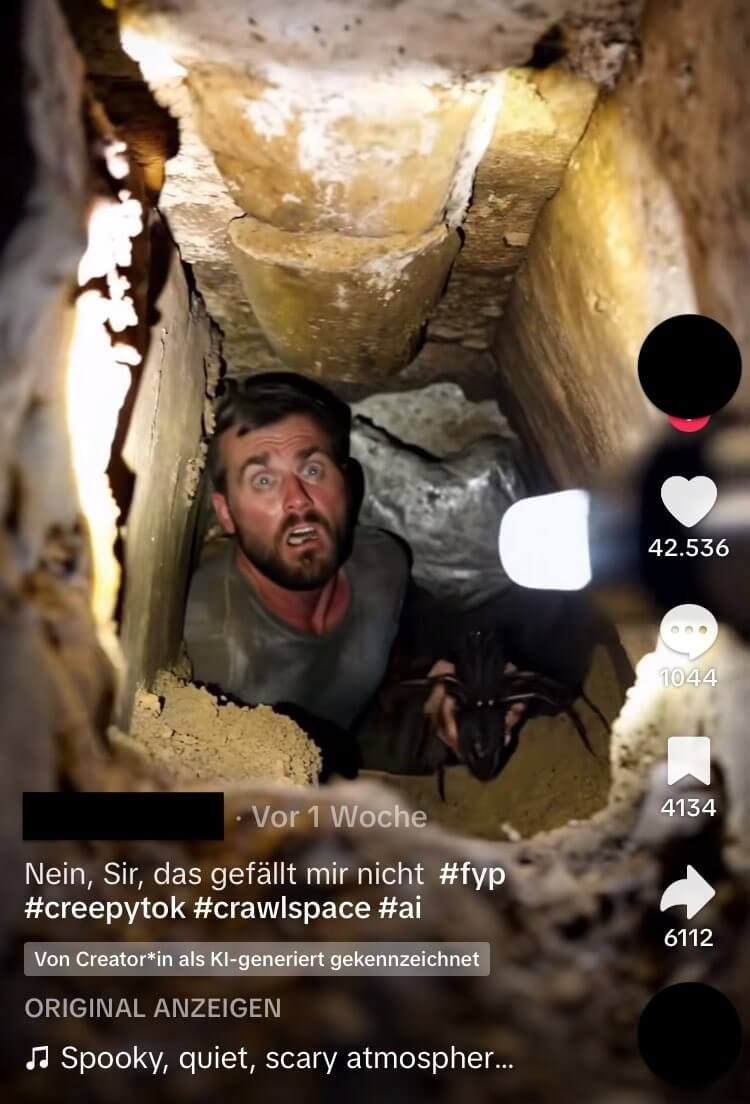

In Sozialen Netzwerken kursiert ein Bild mit besserer Auflösung: Das zeigt angeblich einen Gefangenen, der aus einem Tunnel unter der Erde aus Sednaya entkommt. Das Foto mit der Behauptung verbreitet sich in mehreren Sprachen auf X, Facebook, Instagram, Telegram und Tiktok. Vereinzelt findet es sich auch in Medienberichten, zum Beispiel in Österreich oder Albanien. Doch eine Suche nach dessen Ursprung zeigt: Das Foto ist fake.

Kein Bezug zu Syrien: Hinter dem Bild steckt ein Video, das auf Tiktok als KI-generiert gekennzeichnet ist

Wie die Faktencheck-Redaktionen Teyit und Misbar berichteten, stammt das Bild des angeblichen Gefangenen aus einem Video auf Tiktok. Die Szene zeigt einen Mann, der aus einem Tunnel steigt. Er hält ein schwarz-braunes, künstlich wirkendes Insekt, das größer als seine Hand ist. Seine Zähne sehen aus wie Vampirzähne.

Das Video ist als KI-generiert gekennzeichnet. In der Beschreibung des Tiktok-Profils, auf dem das Video ursprünglich veröffentlicht wurde, heißt es zudem auf Englisch: „Alles hier ist Künstliche Intelligenz.“

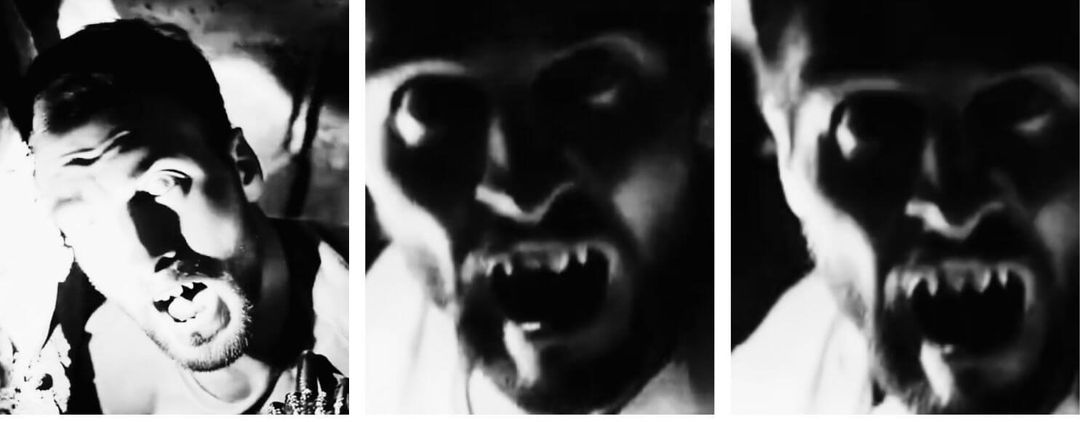

An Vampirzähnen und unnatürlichen Fingern ist erkennbar, dass das Video KI-generiert ist

Auch Fachleute halten das Video für KI-generiert. Siwei Lyu, Direktor des Media Forensic Lab an der US-Universität Buffalo in New York, schreibt uns: „Durch Verlangsamung des Videos werden Ungereimtheiten sichtbar.“ Darauf verweist auch Martin Steinebach, Abteilungsleiter für Media Security und IT Forensic am Fraunhofer-Institut für Sichere Informationstechnologie in Darmstadt. Laut ihm sei ein Problem künstlich erstellter Videos derzeit noch die Kontinuität. Häufig veränderten sich eigentlich unveränderliche Details. Das sei in diesem Fall gut an den Zähnen des Mannes erkennbar. Im Verlauf des Videos verformen sich die anfangs normalen Zähne zu Vampirzähnen:

Ein genauer Blick auf die Hand des Mannes zeigt auch: Seine Finger werden im Video unnatürlich dargestellt. Das ist ein typisches Merkmal KI-generierter Inhalte, das wir auch in anderen Fällen beobachtet haben.

„Auch Schatten und Beleuchtung verhalten sich unrealistisch“, schreibt Steinebach weiter. Hinter der Person entsteht eine Lichtquelle:

Auch Lyu schreibt, dass das Verhalten von Schatten, Spiegelung oder die Interaktion zwischen Objekten bei KI-generierten Inhalten manchmal nicht mit der physischen Realität übereinstimmen würde.

Wie sich manipulierte Bilder enttarnen lassen:

- Wenn Sie unsicher sind, ob ein Ereignis so stattgefunden hat, wie es auf einem Bild zu sehen ist: Suchen Sie mit Stichworten nach potenziellen Medienberichten zu dem Ereignis.

- Achten Sie, wie oben beschrieben, auf Ungereimtheiten und Details in dem Bild.

- Suchen Sie, wenn möglich, nach der ursprünglichen Quelle für das Bild. Helfen kann dabei manchmal auch eine Bilderrückwärtssuche. Wie die funktioniert, können Sie hier nachlesen.

Redigatur: Sarah Thust, Uschi Jonas