KI-Modelle generieren Texte, Bilder und Videos – und entfernen sich dabei mitunter weit von der Realität. Aktuell zeigen Systeme wie ChatGPT, DALL-E und Stable Diffusion eindrucksvoll, wozu lernende Systeme in der Lage sind. Viele Menschen können erstmals mit den Modellen interagieren, Szenarien ausprobieren und Anwendungsfälle testen. „Dieser Schritt ist besonders wichtig und gerade für die Awareness-Bildung essenziell“, sagt Martin Boyer, Projektleiter und Senior Research Engineer am AIT Austrian Institute of Technology im Center for Digital Safety and Security. „Auch führen uns diese Entwicklungen vor Augen, wie wichtig es ist, Infos im Netz immer kritisch zu hinterfragen.“

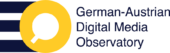

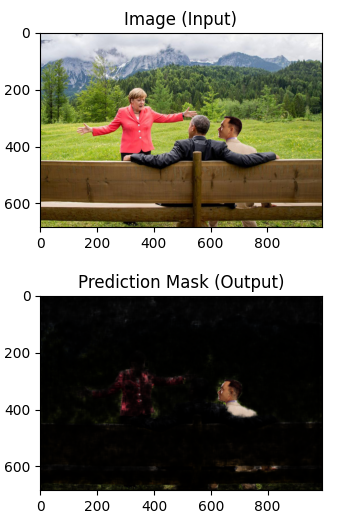

Doch die Verifikation von Inhalten wird zunehmend schwieriger. Schließlich ist ihre Fälschung mithilfe von Software auch ohne große Expertise möglich und kann auf herkömmlichen Rechnern fabriziert werden. Etwa bei sogenannten Deepfakes: In Videos werden vornehmlich prominenten Personen täuschend echt Aussagen in den Mund gelegt, die sie so nie getätigt haben. Die Manipulation zu erkennen, ist mit bloßem Auge oftmals kaum möglich. Damit Faktenchecks dennoch möglich sind, entwickelt das AIT medienforensische Assistenzsysteme für die Verifikation von Bildern und Videos – ein wichtiger Baustein im GADMO-Projekt.

Manipulierten Daten auf der Spur

Häufig zeigen manipulierte Dateien charakteristische Spuren, die auf eine Fälschung hindeuten können. Anwenderinnen und Anwender der Systeme erhalten dann einen Hinweis, können weitere Recherchen anstellen und müssen letztlich entscheiden, ob sie den Inhalt als manipuliert einstufen. „Unsere Tools sollen die Einschätzung eines Menschen unterstützen“, so Martin Boyer. „Gegenwärtig wird zum Beispiel bei der Erkennung von künstlich erzeugten Gesichtern bereits eine sehr hohe Genauigkeit erreicht. Hier haben wir mit der menschlichen Beurteilung schon sehr große Schwierigkeiten.“ Grundsätzlich spiele zudem der Faktor Zeit eine wichtige Rolle: Je mehr Energie und Fachwissen in eine Fälschung gesteckt wurde, desto schwieriger ist es in der Regel auch, sie aufzuspüren.

Künstliche Intelligenz kommt im Entwicklungsprozess dieser Werkzeuge an mehreren Stellen zum Einsatz. Einerseits lernen KI-Modelle anhand früherer Fälschungen, welche verdächtigen Merkmale diese gemeinsam haben – eine zentrale Grundlage für die spätere Identifikation neuen Materials. Zudem verwendet das AIT-Team generative Modelle, um synthetische Datensätze für das Training ihrer Assistenzsysteme zu erzeugen. Schließlich ist keines der von DALL-E oder Stable Diffusion generierten Bilder echt, was sie zum idealen Trainingsmaterial für medienforensische KI-Systeme macht.

Im Grunde ist es jedoch ein Wettrennen. Die einen nutzen lernende Algorithmen, um Inhalte künstlich zu generieren, die anderen zur Identifikation dieser Fälschungen. Und da sich die Technologien für das Manipulieren ständig weiterentwickeln, müssen die Erkennungstools nachziehen und regelmäßig aktualisiert oder erweitert werden. „Zudem kommen bei der Detektion von generierten oder veränderten Inhalten mehrere Analysemethoden zur Anwendung, deren Ergebnisse gemeinsam und in verständlicher Weise präsentiert werden müssen“, so Martin Boyer.

Verständlich bedeutet in diesem Fall: Die forensischen Assistenzsysteme müssen auch auf die Fähigkeiten und Grenzen der Erkennungsmethoden selbst hinweisen, um das nötige Grundwissen für eine fundierte Bewertung digitaler Inhalte zu vermitteln. „Wir entwickeln KI-Tools, um Menschen zu helfen, mit der Komplexität der Digitalisierung umzugehen“, so Martin Boyer. „Technologie ist ein wichtiges Vehikel, um Medien und Behörden im Arbeitsalltag zu unterstützen.“ Im GADMO-Projekt entwickeln Forschende und Faktenchecker die AIT-Werkzeuge gemeinsam weiter, um die spezifischen Herausforderungen durch Desinformationskampagnen noch besser zu adressieren. Zu den Ergebnissen erfahren Sie an dieser Stelle später mehr.

AIT-Kontakt:

Mag. (FH) Michael W. Mürling

Marketing and Communications Manager

Center for Digital Safety & Security

AIT Austrian Institute of Technology

E-Mail: [email protected]

Web: https://www.ait.ac.at/dss/

*Montagebild: AFP/MICHAEL KAPPELER/Paramount/Reddit/grenthdascalon