Ob Midjourney, DALL-E, Stable Diffusion oder Craiyon – in den vergangenen Monaten haben die rasanten Fortschritte in Sachen künstlicher Intelligenz (KI) dazu geführt, dass massenhaft künstlich erzeugte Bilder in sozialen Netzwerken geteilt werden. Einige extrem realistisch anmutende KI-Bilder sorgten dabei für Verwirrung im politischen Tagesgeschehen und wurden in einigen Fällen als authentisch dargestellt. Obwohl es bislang kein Werkzeug gibt, um ein künstlich generiertes Bild mit Sicherheit zu erkennen, verraten sich die KI-Erzeugnisse durch Unstimmigkeiten im Bild oder den Kontext tatsächlicher Ereignisse. Das erklärten Expertinnen und Experten gegenüber AFP.

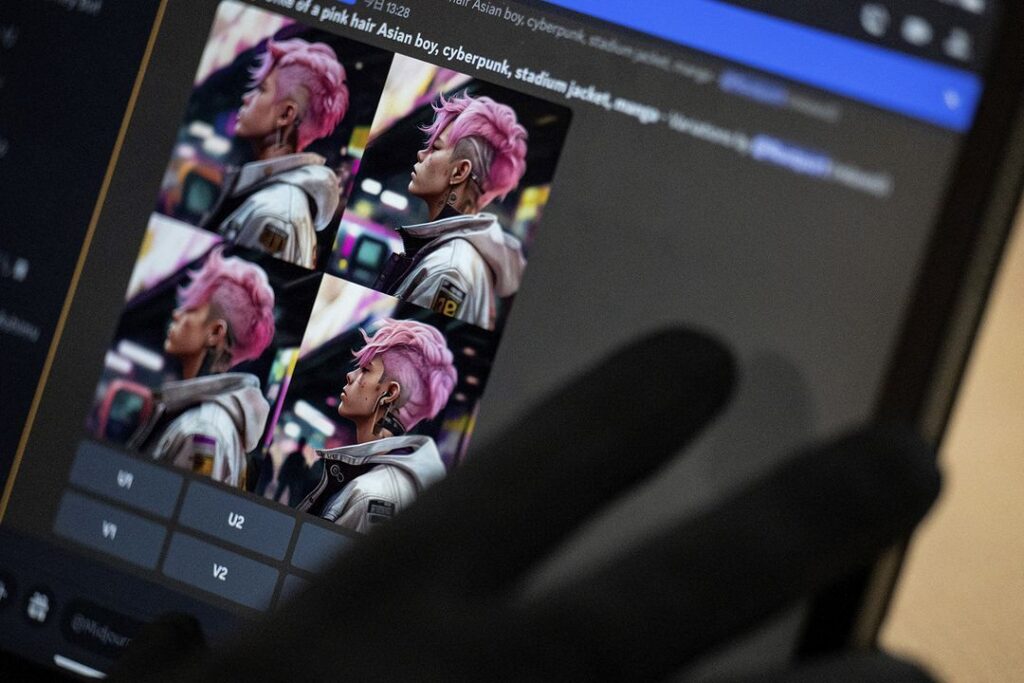

Es braucht nur einige deskriptive Stichwörter und ein Bild entsteht. So funktionieren viele künstliche Intelligenzen wie Midjourney, DALL-E, Craiyon oder auch Stable Diffusion. Mit Hilfe einer riesigen Datenbank, die ständig durch Anfragen von Nutzerinnen und Nutzern erweitert wird, schaffen es diese Tools, unendlich viele Ideen visuell umzusetzen.

Aber wie lässt sich erkennen, ob ein Bild von einer künstlichen Intelligenz erzeugt wurde? Viele User nutzen die KIs für künstlerische oder humoristische Zwecke. Andere verbinden die KI-Bilder mit dem politischen Tagesgeschehen.

Auf Twitter verbreiteten sich beispielsweise KI-Bildern, die echte Ereignisse illustrierten, wie das Zusammentreffen von Wladimir Putin und Xi Jinping am 20. März 2023 in Moskau. Andere Bilder zeigten hingegen fiktive Situationen, wie den französischen Präsidenten Emmanuel Macron, der während Protesten gegen seine Rentenreform Müll in den Straßen von Paris wegräumt.

Hi, I’m a tech reporter that covers China, cybersecurity, & new media. Hundreds of people are sharing this photo of Xi Jinping & Vladimir Putin as they meet at the Kremlin. The two did meet, but it’s highly likely this photo was generated by an AI program. Here’s why: pic.twitter.com/6xqsDLxiMa

— Amanda Florian 小爱 (@Amanda_Florian)

March 21, 2023

L‘#ia#photo a fait des progrès démentiels en très peu de temps, désormais le #fake sera la norme sur les #reseaux, doutez de ce que vous voyez par défaut, plus le choix.#midjourney#midjourneyv5pic.twitter.com/dJoZXGrbRy

— Cryptonoo₿ From 100K to 0 (@Cryptonoobzzzz)

March 19, 2023

Auch wenn die meisten Urheber der KI-generierten Bilder angeben, dass es sich um Fälschungen handelt, passiert es immer wieder, dass die Bilder ohne diesen Hinweis weiterverbreitet oder gar als authentisch dargestellt werden.

Um die KI-generierten Bilder zu erkennen, wurden und werden Tools wie dieses hier entwickelt, die dabei behilflich sein sollen. Deren Ergebnisse sind aber nicht immer verlässlich und können manchmal sogar irreführend sein, wie Versuche von AFP ergaben.

David Fischinger, KI-Spezialist und Ingenieur am Austrian Institute of Technology (AIT), erklärte die Funktionsweise der Bilderzeugung am 21. März 2023 gegenüber AFP: „Wenn eine KI ein Bild vollständig generiert, nimmt sie in der Regel nicht Teile eines einzigen Fotos. Es werden Tausende oder sogar Millionen von Fotos verwendet, um Milliarden von Parametern zu berücksichtigen.”

Vincent Terrasi, Mitbegründer von Draft & Goal, einem Start-up, das unter anderem einen Detektor für KI-generierte Inhalte für Universitäten auf den Markt gebracht hat, ergänzte dazu am 21. März 2023 gegenüber AFP: „Die KI mischt diese Bilder aus ihrer Datenbank, dekonstruiert sie und baut dann Pixel für Pixel ein Foto wieder auf, was bedeutet, dass man in der endgültigen Wiedergabe den Unterschied zwischen den ursprünglichen Bildern nicht mehr bemerkt.“

Aus diesem Grund funktioniert Software, die eine Fotomontage erkennen kann, nicht oder nur sehr schlecht, wenn es darum geht, vollständig von einer KI erzeugte Bilder aufzuspüren.

Die Metadaten eines Fotos, der digitale Fingerabdruck einer Datei, der in manchen Fällen verraten kann, mit Hilfe welcher Website ein KI-generiertes Bild erzeugt wurde, sind bei einem viralen Bild ebenfalls nicht hilfreich: „Leider können sie sich nicht darauf verlassen, da die sozialen Netzwerke diese Informationen systematisch löschen“, sagte Annalisa Verdoliva, Professorin an der Universität Neapel Federico II und KI-Expertin, am 23. März 2023 gegenüber AFP.

Die Bildquelle zurückverfolgen

Die beste Methode, um per KI generierte Bilder zu erkennen, bleibt nach Ansicht der Expertinnen und Experten, den ursprünglichen Kontext des Bildes zu ermitteln, um zu sehen, ob ein User online erklärt hat, dass er das Bild erstellt hat und mit welchem Werkzeug, wie es häufig der Fall ist.

Teil dieser Bildsuche ist es herauszufinden, wann das Foto zum ersten Mal online erschienen ist.

AFP nutzt dafür eine umgekehrte Bildsuche, die auch häufig bei der Recherche von Faktenchecks zur Anwendung kommt. Dabei wird das betreffende Bild in eine oder mehrere Suchmaschinen hochgeladen, um zu sehen, ob es dort bereits indiziert wurde.

Diese Suchmethode kann beispielsweise dabei helfen, den Ursprung einiger Fotos zu finden, die im März 2023 in sozialen Netzwerken kursierten und eine angebliche Verhaftung des ehemaligen US-Präsidenten Donald Trump zeigen sollen.

Eine umgekehrte Bildsuche führte zu einem der Bilder in einem Tweet von Eliot Higgins, dem Gründer des investigativen Rechercheprojekts Bellingcat, der am 20. März 2023 veröffentlicht wurde. In einem Thread erklärt Higgins zu dem Bild, dass er die vermeintlichen Fotos mithilfe der neuesten Version von Midjourney erstellt hat.

Making pictures of Trump getting arrested while waiting for Trump’s arrest. pic.twitter.com/4D2QQfUpLZ

— Eliot Higgins (@EliotHiggins)

March 20, 2023

Sollte das Original nicht in den Suchergebnissen auftauchen, kann die umgekehrte Bildsuche auch zu einer besseren Version des Bildes führen. In manchen Fällen werden die Bildausschnitte von Fotos beschnitten oder verändert oder das Bild verliert an Qualität. Je besser allerdings die Qualität des Bildes ist, desto einfacher ist es auch, Fehler zu finden, die auf eine Fotomontage hindeuten.

Schließlich bietet die umgekehrte Bildsuche auch den Vorteil, dass ähnliche Aufnahmen ausfindig gemacht werden können. Das kann hilfreich sein, um ein mutmaßliches KI-Bild mit Aufnahmen aus vertrauenswürdigen Quellen zu vergleichen.

So identifizierte beispielsweise der italienische Journalist David Puente im Zusammenhang mit dem Treffen zwischen Wladimir Putin und Xi Jinping ein möglicherweise durch KI generiertes Bild. Das ohne Quellenangabe verbreitete Bild, auf dem Putin vor Xi kniet, zeigt andere Details in der Aufmachung des Saals als Fotos, die Medien von dem Treffen veröffentlichten, was Zweifel an der Echtheit des Bildes aufkommen ließ.

Auch die Bildbeschreibung und Userkommentare können dabei helfen, Montagen zu erkennen oder gar den typischen Stil einer KI auszumachen. Während DALL-E beispielsweise besonders für seine extrem realistischen Designs bekannt ist, fällt Midjourney mit seinen Darstellungen von Prominenten auf.

Ein Hinweis auf die KI hinter einer Montage kann dabei helfen, den Ursprung der Bilder ausfindig zu machen. Einige Tools wie Midjourney hinterlassen in verschiedenen Gesprächskanälen eine Spur der erstellten Bilder oder versuchen, ähnliche neue Bilder zu generieren.

Sollte aber keine Quelle des Bildes auffindbar sein und sich kein Hinweis auf den Kontext der Darstellung ergeben, muss das Bild an sich untersucht werden.

Analyse von KI-Bildern

- Wasserzeichen suchen

In manchen Fällen verstecken sich die Hinweise bereits im Foto: Einige Websites platzieren ein Wasserzeichen auf den erstellten Bildern. Das ist zum Beispiel bei DALL-E der Fall – das Tool erzeugt automatisch einen mehrfarbigen Balken in der unteren rechten Ecke aller Bilder. Craiyon platziert an derselben Stelle einen kleinen roten Farbstift.

Achtung: Nicht alle KIs wenden ein Wasserzeichen auf ihre Bilder an, und es kann passieren, dass das Wasserzeichen später entfernt, beschnitten oder maskiert wurde.

- Körnung des Bildes beachten

„Im Zweifelsfall muss man die Körnung des Bildes beobachten, die sich bei einer KI-Erstellung derzeit noch sehr von der eines echten Fotos unterscheiden wird“, betonte Tina Nikoukhah, Doktorin für Bildverarbeitung am Mathematiklabor der ENS Paris-Saclay, am 22. März gegenüber AFP.

Die von AFP getesteten kostenlosen Versionen der KIs erzeugten die Bilder in einem Stil, der den Gemälden des Hyperrealismus recht ähnlich war, wie dieses Beispiel eines Bildes von „Brad Pitt in Paris“ zeigt, das auf Stable Diffusion generiert wurde (unten links).

Ein anderes Bild, das auf Dall-E mit ähnlichen Stichwörtern erstellt wurde (unten rechts), ist naturgetreuer. Auf den ersten Blick ist es schwieriger zu erkennen, dass es sich um ein von einer KI erstelltes Bild handelt.

- Visuelle Unstimmigkeiten suchen

Trotz der rasanten Entwicklungen in der künstlichen Intelligenz, beinhalten die durch KI erzeugten Bilder nach wie vor viele Fehler. Diese seien im Moment das beste Mittel, um ein künstlich erzeugtes Bild zu erkennen, erklärten die von AFP befragten Expertinnen und Experten.

„Bestimmte Merkmale, oft dieselben, bereiten den KIs Probleme. Es sind diese Inkonsistenzen und Artefakte, die man wie bei einem Bilderrätsel untersuchen muss“, hob Vincent Terrasi hervor.

Annalisa Verdoliva warnte jedoch: „Allerdings werden die KIs von Tag zu Tag besser und weisen immer weniger Anomalien auf, sodass man sich langfristig nicht auf visuelle Hinweise verlassen sollte.” Im März 2023 haben die KIs beispielsweise immer noch Schwierigkeiten, realistische Hände zu generieren. Das ist auch auf dem Brad Pitt-Bild von Stable Diffusion zu sehen. Dort wird Pitt mit unnatürlich großen Fingern dargestellt.

So wies zuletzt auch eine AFP-Journalistin auf Twitter auf eine Bild-Montage hin, die angeblich zeigen sollte, wie bei einer Demonstration gegen die Rentenreform in Frankreich am 7. März 2023 eine Demonstrantin von einem Polizisten umarmt wird. Beim Blick auf die Hand des Mannes fällt auf, dass dieser sechs Finger hat.

The hand strikes again: these photos allegedly shot at a French protest rally yesterday look almost real – if it weren’t for the officer’s six-fingered glove #disinformation#AIpic.twitter.com/qzi6DxMdOx

— Nina Lamparski (@ninaism)

February 8, 2023

„Derzeit haben KIs auch enorme Schwierigkeiten, Spiegelungen zu erzeugen. Eine gute Möglichkeit, eine KI zu erkennen, besteht darin, nach Schatten, Spiegeln und Wasser zu suchen, aber auch in die Augen zu zoomen und die Pupillen zu analysieren, da es normalerweise eine Spiegelung gibt, wenn man ein Foto macht. Oft kann man auch feststellen, dass die Augen nicht gleich groß sind und manchmal unterschiedliche Farben haben“, betonte Vincent Terrasi.

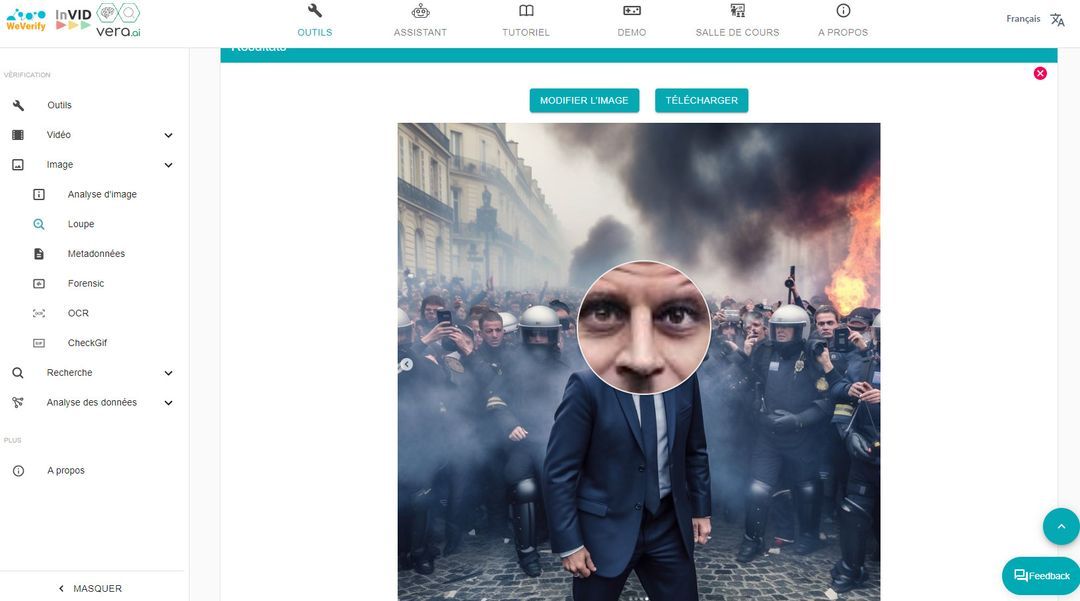

Das ist zum Beispiel bei diesem von einer KI erzeugten Foto von Emmanuel Macron der Fall, das auf Instagram geteilt wurde. Das Tool Invid-WeVerify erlaubt es, mit einer Lupenfunktion einen Farbunterschied zwischen den beiden Augen hervorzuheben.

Die von KIs generierten Bilder können häufig asymmetrisch erscheinen. Das zeigt sich beispielsweise im Gesicht, das unproportional groß wirken kann, oder in bestimmten Merkmalen wie Ohren, die nicht auf gleicher Höhe sind oder nur einen einzigen Ohrring aufweisen.

Auch Zähne und Haare sind für künstliche Intelligenzen schwer nachzuahmen und können aufgrund ihrer Textur oder am Übergang zum Rest des Körpers zeigen, dass das Bild nicht echt ist. Auch Elemente wie Sonnenbrillen können unter Umständen falsch integriert werden und verschmelzen möglicherweise mit dem Gesicht.

Die Expertinnen und Experten wiesen zudem darauf hin, dass das Mischen mehrerer Bilder durch die KI zu Beleuchtungsproblemen im Bild führen könne.

Auch im deutschsprachigen Raum finden sich solche Beispiele. So teilte Norbert Kleinwächter, stellvertretender Vorsitzender der AfD-Bundestagsfraktion, am 21. März 2023 einen Instagram-Beitrag gegen zunehmende Geflüchtetenzahlen. Zur Illustrierung verwendete Kleinwächter ein Foto zahlreicher aggressiv wirkender und schreiender Männer, das zahlreiche Merkmale eines KI-Bildes aufweist. Einige der Gesichter und Münder wirken verschwommen. Im Vordergrund ist eine Hand zu sehen, die scheinbar fünf Finger, aber keinen Daumen aufweist. Dazu kommt die Darstellung der Gesichtsmerkmale wie beispielsweise Falten und Zähne, was auch einige Twitter-User bemerkten.

- Auf den Bildhintergrund achten

Der beste Weg, Anomalien zu erkennen, ist oft, den Hintergrund des Fotos zu untersuchen. Ein KI-generiertes Foto mag auf den ersten Blick zwar normal aussehen, doch im Hintergrund sind oft zahlreiche Fehler zu erkennen, die in einigen Fällen Unstimmigkeiten aufweisen.

So zeigten die folgenden realistisch anmutenden Bilder von Barack Obama und Angela Merkel am Strand, die in sozialen Netzwerken die Runde machten, einen deutlich bearbeiteten Hintergrund: Einer der Personen im Hintergrund sind die Beine abgeschnitten.

„Je weiter ein Element entfernt ist, desto unschärfer, verzerrter und perspektivisch falscher wird ein Objekt erscheinen“, erklärte Vincent Terrasi.

Auf dem gefälschten Foto des Treffens zwischen Xi Jinping und Wladimir Putin ist im Bildhintergrund eine ungerade Kante an einem Pfeiler zu sehen. Dazu kommt, dass der Kopf von Wladimir Putin im Vergleich zum Rest seines Körpers überdimensioniert wirkt.

- Der gesunde Menschenverstand

Auch Elemente, die nicht unbedingt verzerrt sind, können dennoch auf einen logischen Fehler hindeuten. „Es ist gut, sich auf den gesunden Menschenverstand zu verlassen“, sollte man an einem Bild zweifeln, so Terrasi.

Auf einem von AFP auf Midjourney erstellten Bild, das angeblich Paris zeigen soll, ist beispielsweise ein blaues Verbotsschild zu sehen, ein Verkehrszeichen, das es in Frankreich einfach nicht gibt.

Weitere Hinweise darauf, dass es sich hier um ein KI-erzeugtes Bild handelt, sind die abgeschnittenen Fingerspitzen des Mannes, ein Croissant mit plastikähnlicher Textur und die unterschiedliche Ausleuchtung in einigen Fenstern. Das Wasserzeichen in der unteren rechten Ecke des Bildes belegt letztendlich eindeutig, dass das Bild von DALL-E generiert wurde.

Für Bilder, die angeblich echte Ereignisse zeigen, ist es im Zweifel am besten, nach Informationen und Berichten zu suchen, die belegen könnten, ob das Ereignis tatsächlich stattgefunden hat. Falls ja, helfen die dort entstandenen Bilder dabei, um mögliche falsche Aufnahmen zu erkennen.

Bei einem Treffen zwischen Spitzenpolitikerinnen und -politikern können beispielsweise die Kleidung, die Umstände des Zusammentreffens, das Wetter, die Umgebung oder auch Menschen im Bildhintergrund verraten, ob es sich um authentische Aufnahmen handelt.